Beim Tagesgespräch ging es dann darum, wie man die Möglichkeiten von ChatGPT im eigenen Unternehmenskontext nutzen könnte. “Wäre es nicht möglich, unsere Arbeitsanweisungen in die KI reinzubekommen und über Microsoft-Teams verfügbar zu machen”, faszinierte unser Vorstand Dirk Bode beim Essen.

Mich ließ dieser Gedanke auf dem Weg zur Kaffeemaschine nicht los. Ist das nicht ein gutes Thema, um Low-Code drauf zu schmeißen und sehr schnell mit einer fertigen Lösung an den Start zu gehen?

Wie kann (Chat)GPT dazu lernen?

Als erstes war für mich die Frage wichtig, ob ich in der Lage bin, (Chat) GPT neue Dinge beizubringen. Wenn überhaupt, dann nur über die Schnittstelle von OpenAI. Dort kann man sich für den Zugang auf eine API registrieren, mit der man aus einer Software heraus (also auch aus LowCode) Anfragen schicken kann.

Die Dokumentation bietet derzeit nur wenige Informationen, aber es gibt welche. Nach meinem aktuellen Verständnis gibt es zwei Wege, der KI etwas Wissen mitzugeben.

- Im Kontext der Anfrage: Mit jeder Anfrage lassen sich etwa 3000-4000 Wörter mitgeben, die GPT3 zusätzlich für die Beantwortung der Fragen nutzt. Das hilft dann bereits beim Beantworten von Fragen im Kontext des eigenen Unternehmens.

- Few-Shot-Learning: Man kann die KI mit Hilfe eines eigenen Datensatzes weiter trainieren. Dazu erstellt man Frage-Antwort-Paare und trainiert auf einem der GPT3-Modelle weiter.

Eine Demo mithilfe des Kontextes war schnell gebaut. Durch Retool erstellte ich eine kleine Maske, in der man den Kontext bearbeiten, speichern und neue Anfragen stellen kann. Die KI antwortet erstaunlich gut auf viele der Fragen.

Leider antwortet die KI auch auf Fragen, zu denen im Kontext keine Informationen stecken. Die Antworten klingen dann zwar richtig, sind es aber ganz und gar nicht.

Mir wurde schnell klar, dass ich allein mit dem Kontext nicht sehr weit kommen werde. Also heißt es trainieren, trainieren, trainieren.

Für das Training braucht es aber viele Daten. Daher habe ich einiges an Zeit in den Prototypen investiert, sodass die Antworten über die Oberfläche auch korrigiert und bewertet werden können.

Mit dieser ersten Version schickte ich den Bot auf Reisen durch unser Intranet, um zu sehen, welche Fragen die Kollegen stellen würden.

In der Datenbank tummelten sich sehr schnell die wildesten Fragen. Von Bedienungsanleitungen zu unseren Druckern, über fachliche Fragen, bis hin zu Fragen zur Unternehmensgeschichte.

Alleine würde ich das Modell nicht pflegen können. Ich brauchte Unterstützung um die Inhalte für das KI-Training aufzubereiten.

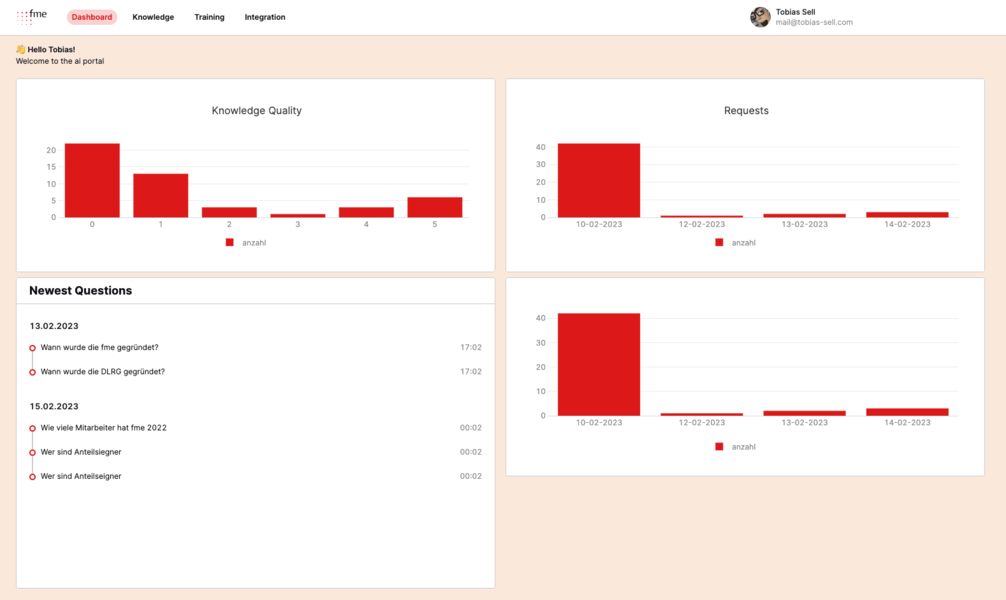

Ein KI-Portal musste her! Folgende Aufgaben sollte das Portal übernehmen:

- Einblick über die aktuellen Anfragen

- Moderation der Antworten

- Export eines Trainingsmodells

- Verwaltung der Modelle für das Frontend

- Einbindung in Microsoft Teams

Die Entwicklung mit Hilfe von Low-Code dauerte nur einen halben Tag. Dann stand das Portal und ich konnte in einem ausgewählten Moderatoren-Kreis die Zugangsdaten tauschen.

Jetzt besteht die Aufgabe zunächst darin, die Antworten von GPT3 zu korrigieren und dann ein neues Modell zu erzeugen.

Ob wir damit die falschen Antworten in den Griff bekommen, wird sich zeigen. Ich vermute aber, dass bei OpenAI bereits selbst an einer Lösung gearbeitet wird, sodass wir in einigen Monaten auf eine fertige Lösung zugreifen können.

Weiter Trainingsdaten zu sammeln schadet bis dahin nicht. Je früher man damit anfängt, desto besser.

Aktueller Stand und Ausblick

Aktuell haben wir einen kleinen Prototypen in MS Teams eingebunden, der direkt bei OpenAI in der Cloud läuft. Deswegen dürfen wir nur Fragen zu Dingen stellen, die datenschutztechnisch unbedenklich sind. Auch das Modell wird derzeit so trainiert.

Ich gehe davon aus, dass bei Microsoft und OpenAI zur Zeit Überstunden geschoben werden, um eine Enterprise Variante zur Verfügung zu stellen, die es einem auch erlaubt, das Modell mit firmeninternen Daten zu trainieren und zu befragen.

Bis dahin kann ich mein AI-Portal weiter ausbauen und die Trainingsdaten verbessern, sodass wir zum Start einer Enterprise Lösung von GPT3 in der Lage sind, unseren Kunden eine fertige und DSGVO-Konforme Lösung anzubieten.

Wer bis dahin mit uns auf die KI/Low-Code Reise gehen will, kann sich gerne bei mir melden. Der Weg dahin ist aufregend und der Austausch macht jede Menge Freude.

0 Kommentare